【2026年標準】AIエージェントの”USB-C”。Model Context Protocol (MCP) 完全技術解説

「LLMに社内ドキュメントを読ませたいが、RAGの構築が面倒すぎる」

「Claudeとローカルの3Dプリンタログを接続するために、またPythonで別のAPIラッパーを書いている」

もしあなたがそのような「質の低いグルーコード」の修正に追われているなら、この記事はあなたのためのものです。

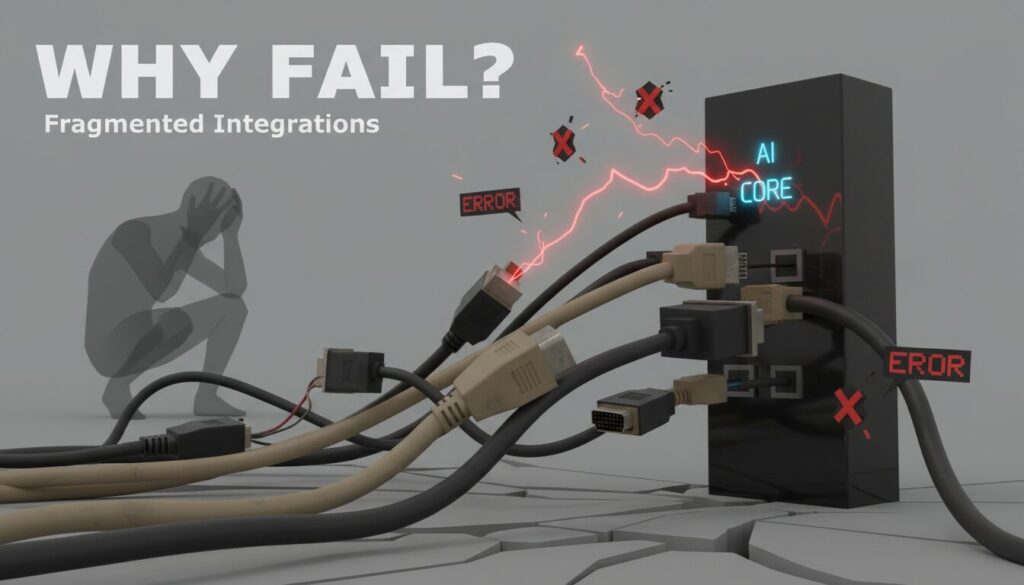

2024年以前、AIエージェントと外部ツールの接続は「無法地帯」でした。

しかし2025年、Anthropicとコミュニティによって策定されたMCPがすべてを変えました。

これはAIエージェントにおける「USB-C」です。もはや、デバイスごとに異なるケーブル(専用プラグイン)を用意する必要はありません。

この記事では、MCPの技術的仕様、アーキテクチャ、そしてエンジニアが知っておくべき「3Dプリンタ x AI」の実装パターンについて解説します。

なぜ「専用プラグイン」は破綻したのか:コンテキストのサイロ化問題

私たちが直面していた課題は、LLMの知能不足ではなく、「コンテキストの供給パイプライン」の欠陥でした。

1. N対Mの接続コスト

従来のパラダイムでは、新しいLLMが出るたびに、既存のツールとの接続コネクタを再実装する必要がありました。

ツールが10個、LLMが3個あれば、30通りのメンテナンスが発生します。これはエンジニアリングリソースの無駄遣いです。

2. 静的なコンテキストウィンドウの限界

「Ctrl+C, Ctrl+V」でログを貼り付ける作業は、エンジニアの仕事ではありません。

また、コンテキストウィンドウが200万トークンに拡大したとはいえ、常に全てのデータをプロンプトに含めるのは、コストとレイテンシの観点から非現実的です。

必要なデータを、必要な時にだけ「プル」する仕組みが欠けていました。

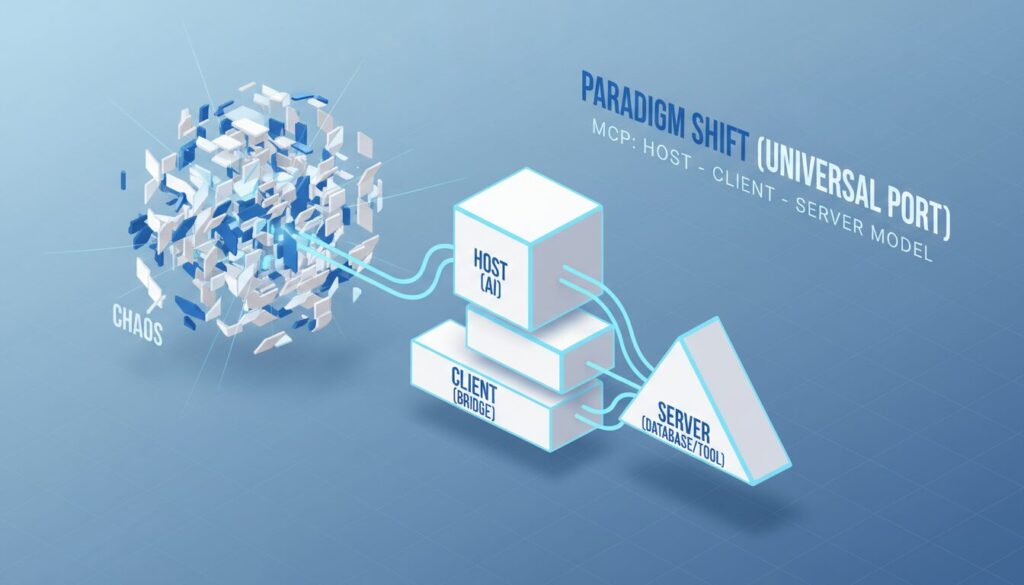

パラダイムシフト:MCPによる標準化アプローチ

MCPは、この「N対M」の問題を「1対1」の接続に単純化します。

アーキテクチャ図解

MCPの美しさは、Host、Client、Server の明確な分離にあります。

sequenceDiagram

participant User

participant Host as MCP Host (Claude Desktop/Gemini)

participant Client as MCP Client

participant Server as MCP Server (Local/Remote)

User->>Host: "Bambu Lab A1の現在のノズル温度は?"

Host->>Client: ツール探索リクエスト (list_tools)

Client->>Server: JSON-RPC request

Server-->>Client: {Tools: ["get_printer_status", "set_temperature"]}

Client-->>Host: ツール定義を返却

Host->>Host: ユーザーの意図を解釈 (get_printer_statusを選択)

Host->>Client: ツール実行 (call_tool: get_printer_status)

Client->>Server: 実行リクエスト

Server-->>Client: {result: {temp: 215.0, status: "Printing"}}

Client-->>Host: 結果をテキストとして渡す

Host-->>User: "現在215℃でプリント中です。"技術的コア:JSON-RPC 2.0とトランスポート

MCPは魔法ではありません。堅牢な JSON-RPC 2.0 プロトコルです。

エンジニアとして注目すべきは、そのトランスポート層の柔軟性です。

- stdio : ローカルプロセスとしてサーバーを起動し、パイプ経由で通信します。セキュリティが高く、Dockerコンテナ内のサーバーや、ローカルファイルシステムへのアクセスに最適です。

- SSE : リモートサーバーとの通信に使用されます。PostmanのようなHTTPベースのやり取りが可能で、社内ネットワーク上のマイクロサービスをAIに公開する場合に威力を発揮します。

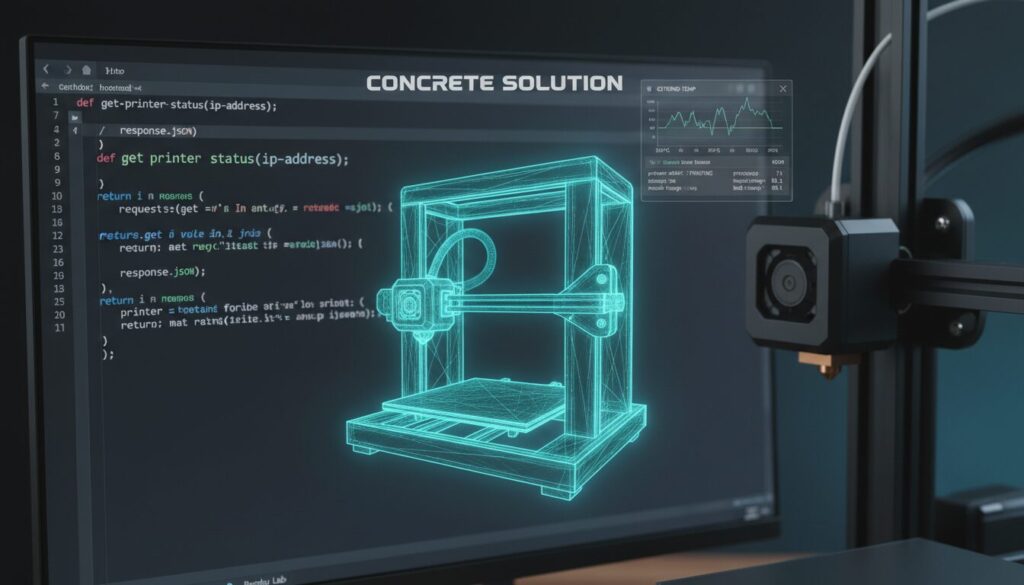

具体的なソリューション:3Dプリンタ監視サーバーの実装

では、実際に「手を動かす」パートに入りましょう。

ここでは、私が普段使用しているBambu Lab製プリンタのステータスを、Claude Desktopから直接確認するためのMCPサーバーの概念実証を紹介します。

技術スタック

- Language: Python 3.12+ (または TypeScript)

- SDK:

mcp(Official Python SDK) - Protocol: MQTT (プリンタとの通信用) -> MCP (AIとの通信用)

Server Code Example (Python)

from mcp.server.fastmcp import FastMCP

import json

# サーバーの初期化

mcp = FastMCP("BambuPrintMonitor")

# 共有ステート(実際にはMQTTコールバックで更新する)

printer_state = {

"nozzle_temp": 0.0,

"bed_temp": 0.0,

"print_progress": 0,

"current_layer": 0

}

@mcp.resource("bambu://status")

def get_printer_status() -> str:

"""現在のプリンタステータスをJSONテキストとして返します"""

return json.dumps(printer_state, indent=2)

@mcp.tool()

def set_nozzle_temperature(temp: int) -> str:

"""ノズル温度を設定します。警告: プリント中は慎重に操作してください。"""

if temp > 280:

return "Error: 温度が高すぎます。"

# ここにMQTT送信ロジックが入る

# mqtt_client.publish(...)

printer_state["nozzle_temp"] = temp

return f"ノズル温度を {temp}℃ に設定しました。"

if __name__ == "__main__":

mcp.run()このわずか30行程度のコードで、あなたのClaudeは物理世界の温度を「認識」し、操作する能力を手に入れます。

従来のAPI開発で必要だった認証フローやSwagger定義は、MCP SDKが抽象化してくれます。

実践ワークフロー:Claude Desktopへの導入

作成したサーバーを実際に使用するには、Host(この場合はClaude Desktop)の設定ファイルに追記するだけです。

設定ファイルの編集:

macOSの場合: ~/Library/Application Support/Claude/claude_desktop_config.json

Windowsの場合: %APPDATA%\Claude\claude_desktop_config.json

JSON設定の追加:

json

{

"mcpServers": {

"bambu-monitor": {

"command": "uv",

"args": ["run", "path/to/server.py"]

}

}

}再起動と検証:

Claude Desktopを再起動すると、チャット入力欄の「プラグイン」アイコン(またはツールアイコン)に bambu-monitor が認識されているはずです。

「今のプリント状況はどう?」と尋ねるだけで、バックグラウンドで bambu://status リソースが読み込まれ、回答が生成されます。

推奨エコシステム

2026年現在、MCPエコシステムは急速に成熟しています。

- Smithery: MCPサーバーのnpm/PyPIのようなレジストリ。ここで既存のサーバー(Postgres, GitHub, Slackなど)を探せます。車輪の再発明は避けましょう。

- Glama: MCPサーバーのデバッグや検査を行うためのインスペクターツール。開発者には必須です。

- Cursor / Windsurf: コードエディタもMCP Clientとしての機能を強化しています。

まとめ

MCPは、AIアプリケーション開発における「ラストワンマイル」を埋める技術です。

これまでは「AIにどうやってデータを渡すか」に悩んでいましたが、MCPによって「どのようなデータを公開するか」という、本質的な設計に集中できるようになりました。

あなたの開発現場でも、独自の社内APIやデータベースへの「MCPアダプタ」を書き始めてください。

それは、あなたのチームのAIエージェントが、真の意味で「同僚」になるための第一歩です。