深く、遅く、賢く。「System 2」を80ドルのRaspberry Pi 5で動かす意味

System 2(熟考型AI)の時代が到来しました。

「AIは速ければ速いほど良い」

2025年まで、私たちはシリコンバレーが作り出したこのドグマを信じて疑いませんでした。Groqが毎秒300トークンを叩き出し、リアルタイム音声対話が普及し、遅延(レイテンシ)は「悪」そのものでした。

しかし、2026年2月。状況は一変しました。

なぜ今、毎秒3トークンしか出ないRaspberry Pi 5に、世界中のハッカーやエンジニアが熱狂しているのでしょうか?

その答えは、OpenAI o1やDeepSeek R1が示した「推論(Reasoning)」パラダイムへのシフトにあります。

AIの価値は「反射神経(System 1)」から「熟考(System 2)」へと移りました。

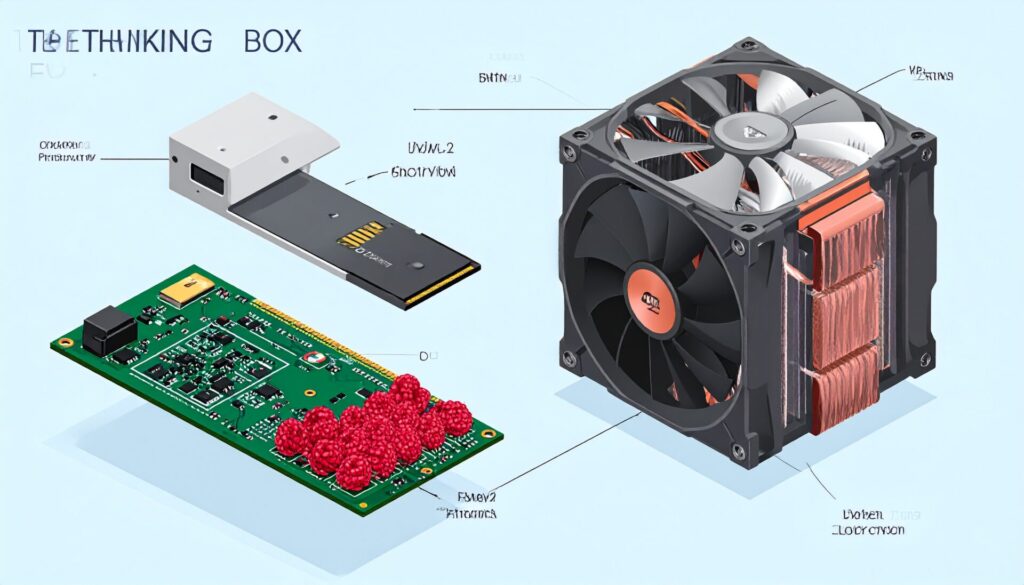

本記事では、15億パラメータ(1.5B)の蒸留モデル(DeepSeek-R1-Distill-Qwen-1.5B)をPi 5 (8GB) で動かし、「3分考えて、完璧な答えを出す」専用デバイスの作り方を解説します。

クラウドにデータを送らず、電気代以外はタダ。あなたの机の上で、夜通し悩み続けてくれる「哲学する箱」を作ってみませんか。

1. なぜ「遅いAI」が必要なのか?:System 2の民主化

しかしながら、クラウド上の巨大LLM(GPT-5やClaude Opus)は優秀ですが、常に「課金(トークンコスト)」と「プライバシー」の問題がつきまといます。つまり、DeepSeek R1のような「思考モデル」は、思考プロセス自体が長大になるため、従量課金だとあっという間に財布が軽くなります。

その一方で、Pi 5上で動くローカルLLMは、初期投資(本体約1.5万円、NVMe SSDやクーラーなどの周辺機器は別途必要)さえ済ませれば、あとは計算し放題です。

したがって、ここに「Slow AI」の勝機があります。

1-1. 速度と精度のトレードオフ

「推論モデル」の特徴は、時間をかければかけるほど精度が向上する(Test-time Compute)点にあります。

- System 1 (反射): 「フランスの首都は?」→「パリ」 (0.1秒)

- System 2 (熟考): 「このRustコードのメモリリークの原因と、スレッドセーフな修正案は?」→

<think>タグ内で数十ステップの検証 → 回答 (10分)

Pi 5の遅さは、欠点ではなく「仕様」です。

コードのリファクタリング案、複雑な契約書のチェック、人生相談。これらは1秒で返ってくる必要はありません。むしろ、一晩かけてでも、何百もの可能性を探索(Tree of Thoughts)してくれた方が、人間にとっては価値があるのです。

1-2. DeepSeek R1 Distillの衝撃

80億パラメータ以下の「Small Language Models (SLM)」の進化は凄まじく、特にDeepSeek R1の蒸留モデルは、数学やコーディングにおいて驚異的な性能を発揮します。

それまで、Pi 5のエッジAIといえば、カメラ映像の物体検出(YOLO)などが主流で、NPU(Hailo-8L)が主役でした。

しかし「推論」においては、汎用的なCPU(Cortex-A76)と大容量RAM (8GB) が主役です。ただし、NPUはまだ「思考の柔軟性」に対応しきれていません。

2. 実践:Pi 5でSystem 2の「哲学する箱」を作る

それでは、実際に構築していきましょう。目標は「電源を入れたら、勝手に思考を開始する」スタンドアロンな推論デバイスです。

2-1. ハードウェア選定:8GB以外は認めない

- Raspberry Pi 5 (8GBモデル): 必須です。4GBモデルでは、OSとモデルを展開した瞬間にスワップ地獄(SDカードへの退避)が始まり、実用速度が出ません。

- NVMe SSD (256GB以上) + PCIe HAT: SDカード(A2クラスでも)では、モデルのロードに分単位の時間がかかります。NVMeなら数秒です。思考の切り替え速度に直結します。

- Active Cooler: これも必須です。推論中のCPUは全コア100%で張り付き、温度は80℃近くになります。ファンなしではサーマルスロットリングで性能が半減します。

なお、 ケースは「中が見える」タイプをお勧めします。ファンが回り、LEDが点滅している様子は、まさに「機械が考えている」風情があります。

2-2. 環境構築 (Ollama on Pi)

さらに、2026年現在、OllamaはARMアーキテクチャに極限まで最適化されています。Dockerすら不要です。

# インストール

curl -fsSL https://ollama.com/install.sh | sh

# サービスとして起動しているか確認

sudo systemctl status ollama2-3. モデルの選択と実行

Pi 5で動かすべき「推論モデル」は限られています。

# 1.5Bモデル(推奨)

ollama run deepseek-r1:1.5b

つまり、たったこれだけです。

DeepSeek-R1-Distill-Qwen-1.5B なら、Pi 5でも 8〜10 tokens/sec で動作します。

これは「人間が黙読する速度/タイピングする速度」より少し速い程度。つまり、リアルタイムでAIの思考プロセス(<think>タグの中身)が流れていくのを眺めるのに、最適な速度なのです。なぜなら、速すぎると目で追えませんが、Pi 5なら「今、ここを悩んでいるな」と共感できます。

3. System 2プロンプト設計:「思考の連鎖」を引き出す

Pi 5のような小規模モデルで高品質な回答を得るコツは、System Promptで「焦らせない」ことです。

なぜなら、デフォルトのままだと、モデルは「早く答えなきゃ」と焦ってSystem 1で回答しがちです。

推奨System Prompt

あなたは熟考する哲学者AIです。

ユーザーの問いに対して、決してすぐに答えを出さないでください。

まずは<think>タグの中で問題を要素分解し、

歴史的背景、技術的制約、倫理的側面など、最低3つの異なる視点からアプローチを検討してください。

時間はかかりすぎても構いません。結論よりも、思考の過程を重視してください。

その上、これをOllamaの Modelfile に保存して、カスタムモデルとして登録しましょう。

4. System 2ベンチマーク:7B vs 1.5B(Pi 5の現実)

筆者が実機で計測したベンチマーク結果です。

| モデル | 量子化 | VRAM使用量 | 速度 | 評価 |

|---|---|---|---|---|

| DeepSeek-R1-Distill-Qwen-1.5B | Q4_K_M | 1.1 GB | 9.8 t/s | [推奨] サクサク動く。論理パズルも解ける。日常会話ならこれで十分。 |

| Phi-4-Mini | Q4_0 | 2.3 GB | 4.2 t/s | 限界ギリギリの実用性。知識量は1.5Bより多いが、待ち時間が気になる。 |

| Llama-3.2-3B | Q5_K_M | 3.4 GB | 2.8 t/s | 遅い。1行生成されるのに待たされる感覚。バックグラウンド処理向き。 |

| DeepSeek-R1-Distill-Llama-8B | Q4_K_M | 5.1 GB | 1.8 t/s | [非推奨] ほぼフリーズしているように見える。対話は不可能。 |

驚くべきことに、1.5Bモデルでも「推論」の片鱗を見せます。

具体的には、単純な知識量(「徳川家康の誕生日は?」)では7Bに劣りますが、論理的整合性(「このPythonコード、どこがバグってる?」)においては、思考プロセスを経ることで7Bモデルと同等以上の鋭い指摘をすることがあります。

5. System 2の未来:分散思考ネットワークとエッジ推論

もちろん、Pi 5が1台では非力でも、4台あればどうでしょうか?

2026年、llama.cpp のサーバー機能を使えば、複数のPi 5で層(レイヤー)を分割担当する「パイプライン並列化」や、異なるモデルを動かして議論させる「会議室アプローチ」も可能です。

家庭内エージェント群の構想

- Pi 5 A号機 (Manager): ユーザーの指示を受け、タスクを分解する。

- Pi 5 B号機 (Coder): コードを書くことに特化したモデル (DeepSeek-Coder系) が常駐。

- Pi 5 C号機 (Critic): 書かれたコードをレビューし、批判する。

例えば、自宅の棚に並んだRaspberry Piたちが、あなたが寝ている間に複雑な科学論文を読み込み、議論し、修正し合い、翌朝には「要約と考察」を提出している。

すなわち、そんな「専用エージェント群」を、月額0円で雇用できる時代。

それが2026年の「Reasoning on Edge」です。

その結果、速さだけが知能ではありません。じっくり考える時間を、シリコンにも与えてあげましょう。

むしろ、私たちの人生と同じで、本当に大事な答えは、即座には出ないものなのかもしれま

さらに詳しくSystem 2の推論技術について知りたい方は、DeepSeek R1公式リポジトリやRaspberry Pi公式ドキュメントも参考にしてください。また、当サイトの関連記事もあわせてお読みください。