[Beyond Copilot] 自律型AIエージェントアーキテクチャ2026: LangGraphで設計する「思考するシステム」

2025年、私たちは「Copilot」の便利さを享受しましたが、2026年は「Agent」の年です。

特に自律型AIの進化に注目が集まっています。

コードを補完するだけのAIから、複雑なタスクを計画

実行し、修正する「思考するシステム」への移行が始まっています。

この記事では、単なるチャットボットを超えた、堅牢な自律エージェントシステムのアーキテクチャを紹介します。

さらに、最新の LangGraph を用いて技術的に解説します。

なぜ「ただのLLMループ」は失敗するのか?

多くのエンジニアが最初に直面する壁、それは「プロンプトチェーンの限界」です。

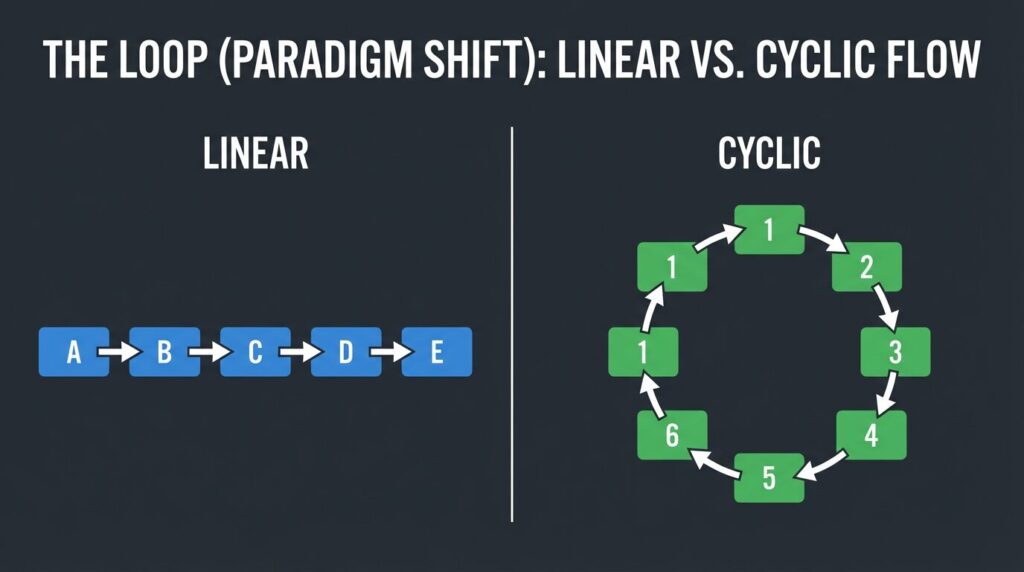

従来の線形なチェーン構造は、予測可能なタスクには適していますが、自律的な意思決定には不向きです。

- 状態保持の欠如: 以前のステップの失敗や中間生成物を記憶し続けることが難しい。

- 柔軟性のなさ: 「エラーが出たら調査に戻る」といった動的なループ処理を実装すると、コードがスパゲッティ化する。

- デバッグの困難さ: ブラックボックス化したエージェントのどこで判断を誤ったかを追跡できない。

これらを解決するのが、グラフ理論に基づいたステート管理です。

パラダイムシフト: “Graph” as a Brain

LangGraphは、エージェントのワークローを「有向グラフ」として定義します。

ここでの重要な概念は Cyclic Graph(循環グラフ) です。

人間が思考する際考え直すように、エージェントも「計画→実行→評価→再計画」というサイクルを回す必要があります。

コアコンポーネント

- State (Schema): エージェントの「短期記憶」。すべてのノードがアクセスし、更新できる共有データ構造。

- Nodes (Agents/Tools): 具体的な作業を行う関数。LLMの呼び出し、Web検索、コード実行など。

- Edges (Control Flow): 次にどのノードに進むかを決定するロジック。条件付きエッジにより動的なルーティングが可能になります。

技術的詳細: Orchestrator-Workers パターン

2026年の主流デザインパターンの一つ、「Orchestrator-Workers」の実装例を見てみましょう。

これは、中央の監督者がタスクを分解し、専門家エージェントに割り振るマイクロサービスのような構成です。

以下は LangGraph を使用した簡略化された Python 実装例です。

from typing import TypedDict, Annotated, List, Union

from langgraph.graph import StateGraph, END

from langchain_core.messages import BaseMessage

import operator

# 1. Stateの定義: メッセージ履歴と現在の担当エージェントを保持

class AgentState(TypedDict):

messages: Annotated[List[BaseMessage], operator.add]

next_agent: str

# 2. ノードの定義 (簡略化)

def orchestrator_node(state: AgentState):

# LLMが会話履歴を分析し、次に呼ぶべきエージェント(Researcher or Coder)を決定

# router_response = llm.invoke(...)

return {"next_agent": "Researcher"} # 仮の決定

def researcher_node(state: AgentState):

# Web検索を実行し、結果をメッセージに追加

return {"messages": [("ai", "Search Results: ...")]}

def coder_node(state: AgentState):

# コードを生成

return {"messages": [("ai", "def hello_world(): ...")]}

# 3. グラフの構築

workflow = StateGraph(AgentState)

workflow.add_node("Orchestrator", orchestrator_node)

workflow.add_node("Researcher", researcher_node)

workflow.add_node("Coder", coder_node)

# 4. エッジの定義 (動的ルーティング)

workflow.set_entry_point("Orchestrator")

def router(state: AgentState):

if state["next_agent"] == "Researcher":

return "Researcher"

elif state["next_agent"] == "Coder":

return "Coder"

return END

workflow.add_conditional_edges(

"Orchestrator",

router,

{"Researcher": "Researcher", "Coder": "Coder", END: END}

)

workflow.add_edge("Researcher", "Orchestrator") # 調査後は監督者に戻る

workflow.add_edge("Coder", "Orchestrator") # コード作成後も監督者に戻る

# 5. コンパイルと実行

app = workflow.compile()このアーキテクチャの美しさは、workflow.compile() によって生成されるランタイムにあります。

これはステートを永続化し、途中でプロセスが落ちても再開可能(Resumable)な基盤を提供します。

Human-in-the-Loop: 信頼のための最後の砦

自律エージェントを本番環境に投入する際、最も重要なのが Human-in-the-Loopです。

完全に自律させるのではなく、重要なアクションの前に「人間の承認」を挟みます。

LangGraphでは、interrupt_before を設定するだけでこれを実装できます。

# Coderがコードを書く前に一時停止

app = workflow.compile(interrupt_before=["Coder"])これにより、システムは Coder ノードに入る直前で停止します。

さらに、人間が現在の Stateを確認・修正した上で、resume コマンドを送るまで待機します。

これが、2026年の「信頼できるエージェント」の標準仕様です。

エージェント思考フローの可視化

この自律的なループ処理を視覚化すると、以下のようになります。

sequenceDiagram

participant User

participant Orchestrator

participant Worker (Researcher/Coder)

participant Memory (State)

User->>Orchestrator: タスク依頼

loop Agent Loop

Orchestrator->>Memory: 現在の状況を確認

Memory-->>Orchestrator: 履歴データ

Orchestrator->>Orchestrator: 計画立案・担当割当

alt 調査が必要

Orchestrator->>Worker (Researcher): 調査指示

Worker (Researcher)->>Memory: 検索結果を保存

else 実装が必要

Orchestrator->>Worker (Coder): コード作成指示

Worker (Coder)->>Memory: コードを保存

end

Worker (Researcher)-->>Orchestrator: 完了報告

end

Orchestrator->>User: 最終成果物を提出推奨スタック (2026 Edition)

堅牢なエージェントシステムを構築するための推奨スタックです。

- Orchestration: LangGraph (ステート管理と制御フロー)

- Validation: Pydantic (構造化データの検証。LLMの出力保証に必須)

- Tools: Tavily (エージェント用に最適化された検索API)

- Observability: LangSmith (エージェントの思考プロセス)

まとめ

「言われたことだけやる」ボットの時代は終わりました。

これからのエンジニアに求められるのは、プロンプトを書くスキル以上に必要なことがあります。

つまり、エージェントが自律的に動くための「場」と「ルール」を設計するアーキテクトとしてのスキルです。

まずは小さな「Cyclic Graph」を作ることから始めてみてください。

それが、AGI(汎用人工知能)への小さな、しかし確実な一歩となるはずです。